大家好,分享一下最近刚开源的音频视频驱动图片说话唱歌的数字人项目AniPortrait,它是由腾讯游戏团队的三位开发者倾力打造,不同于阿里EMO目前仍停留在Readme阶段,腾讯团队推出的AniPortrait项目展现出更为先进的技术和功能,两者形成了鲜明的对比。

这个开源项目有三种生成模式,分别是视频自驱动,面部视频迁移和音频驱动图片,其中,视频自驱动模式下,只需输入图片地址和视频动作地址,在FP16默认精度下,即可生成相应动作的数字人表现;面部视频迁移模式则可实现图片与原视频的面部融合;音频驱动图片模式则可以根据音频地址和图片地址,自动生成与音频口型同步的动态数字人画面。

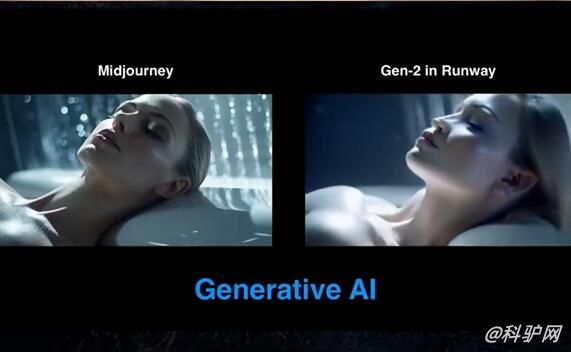

先看效果

首先打开整合包,打开配置文件configs\prompts,

animation.yaml对应视频自驱动,用文本编辑,在test_cases输入图片地址和视频动作地址即可,默认精度是FP16。

animation_facereenac.yaml对应视频驱动换脸,在test_cases输入图片地址和原视频地址即可。

animation_audio.yaml对应音频驱动图片,在test_cases输入图片地址和音频地址即可。

随后回到根目录,执行对应的bat文件即可。

生成出来的视频在项目的output目录中。

尽管项目尚处于起步阶段,但在短短两天内就收获了超过1,100个Star,足见其受欢迎程度。

针对低端GPU用户反映的性能瓶颈问题,有开发者提出了采用lcm lora和AnimateDiff lightning替代原有SD 1.5和AnimateDiff模型的建议,以提高推理速度和适应更多类型的设备。对此,项目作者积极响应并承诺将在后续版本中更新模型架构,进一步优化推理性能,以增强AniPortrait的泛用性和用户体验。

无权限下载附件

AI视频生成工具

AI视频生成工具 0

0