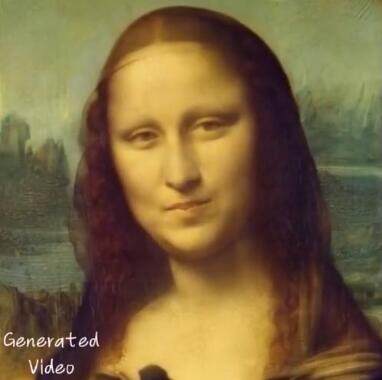

AI如何将图片与声音结合,创造出能跳舞和唱歌的动态图像。Emote Portrait Life通过训练理解语音与口型、表情的关联,生成的表情和动作自然且具有情感表现力。

这是一段罗老师的声音,这是一张高启强的图片,把它们放在一起让 AI 处理一下,就变成了“我都一年没吃苹果了,到超市偷了一袋苹果,大家觉得借不到钱。“

这是一段音乐,这是奥黛丽赫本,把它们融合一下,照片就能唱歌了。

这是动画里的女王,这是现实中的女王。把她们交给 AI 就得到了一个名场面。”不要叫我大王,要叫我女王大人“。

去年年底一个叫 animate anyone 的AI项目突然爆火,它可以随意上传一张人物图片,然后用 AI 控制图片中的人物做出各种动作。后来通义千问APP根据这个项目推出了全民舞王功能,然后我们就有幸看到各种人物跳科目三的视频。

到了今年2月,阿里通义实验室又推出了他们的全新AI项目emote portrait life,简称EMO,这次不再是跳舞,而是控制画面中的人物表情,按照对应的音频张嘴说话唱歌。

不仅口型完全一致,面部表情和头部动作也都非常自然,甚至连微表情都惟妙惟肖。你看着这些视频,甚至有种他有情感的错觉。而这些仅仅是上传一张照片和一段音频之后得到的,之所以能达到这么好的效果,是因为 EMO 使用了一种全新的生成机制,它首先使用了大量的人物讲话视频进行训练,让 AI 理解了语音和人物口型表情的关联关系,有了理解情绪的能力。在生成的时候再用声音来驱动图像,根据语音内容和包含的情绪一帧帧的控制图像,让他表现出与音频内容高度匹配的口型和表情。

如今一个月过去,这个叫 EMO 的大模型终于也上线了通义千问。打开通义,输入大写的EMO,跳转,进入后切换到全民唱演,就能看到很多模板了,我们找到一个喜欢的,点进去选择演同款,上传一张照片,再点击最下面的立即生成。稍微等待一会儿,视频就完成了。

经过我的实测,虽然在上传照片的时候它会提示一些要求,但实际上只要是类人的物体基本上都能成功,比如游戏角色、动画角色。所以它的整活空间非常大,如果大家感兴趣的话,可以到通义中尝试。下载地址:网页链接

AI视频生成工具

AI视频生成工具 0

0